Фишинг

Самым распространенным вариантом использования генеративного ИИ среди преступников на данный момент является фишинг - попытка обманом заставить людей раскрыть конфиденциальную информацию, которая может быть использована в противоправных целях. В сервисы, генерирующие спам, такие как GoMail Pro, интегрирован ChatGPT, который позволяет преступным пользователям переводить или улучшать сообщения, отправляемые жертвам.

Раньше такие схемы можно было распознать, потому что английский язык в сообщениях был неуклюжим и изобиловал грамматическими ошибками. Но сейчас языковые модели позволяют мошенникам генерировать сообщения, которые звучат так, как будто их написал бы носитель языка.

OpenAI утверждает, что для выявления и пресечения неправомерного использования своих моделей она использует сочетание человеческих рецензентов и автоматизированных систем, а также выдает предупреждения, временно приостанавливает работу и запрещает использование, если пользователи нарушают политику компании. В февральском отчете OpenAI сообщила, что закрыла пять аккаунтов, связанных с государственными злоумышленниками.

Мошенничество с deepfake-аудио

Генеративный искусственный интеллект позволил сделать большой скачок в развитии deepfake: синтетические изображения, видео и аудио выглядят и звучат реалистичнее, чем когда-либо. И если deepfake-видеоролики сложны в изготовлении и легче распознаются человеком, то с аудиоподделками дело обстоит иначе. Они дешевы в изготовлении и требуют всего пары секунд чьего-то голоса, взятого, например, из социальных сетей, чтобы создать нечто пугающе убедительное.

Чтобы защитить себя от этого, можно договориться с близкими людьми о регулярно меняющемся секретном безопасном слове, которое поможет подтвердить личность человека на другом конце линии.

Обход проверок личности

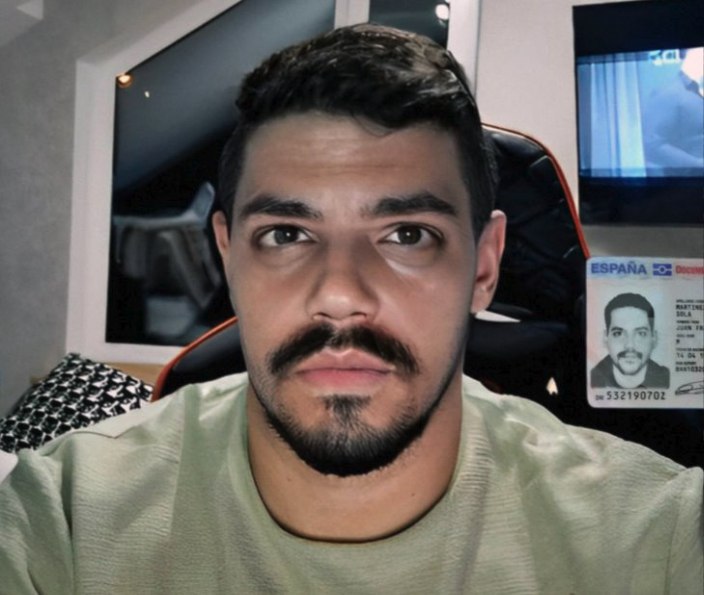

Банки и криптовалютные биржи используют системы безопасности для проверки того, что их клиенты - реальные люди. Они требуют от новых пользователей сфотографироваться перед камерой с физическим документом, удостоверяющим личность. Однако преступники начали продавать на таких платформах, как Telegram, приложения, позволяющие обойти это требование.

Они предлагают поддельное или украденное удостоверение личности и накладывают поверх лица реального человека deepfake-изображение, чтобы обмануть систему верификации на камере телефона. Ниже пример украденного удостоверения личности и преступника, использующего технологию подмены лиц для обхода систем проверки подлинности.

Jailbreak-as-a-service

Компании, занимающиеся разработкой ИИ, применяют различные меры предосторожности, чтобы их модели не выдавали вредную или опасную информацию. Вместо того чтобы создавать собственные модели ИИ без этих гарантий, что дорого, долго и сложно, киберпреступники начали использовать новую тенденцию: jailbreak-as-a-service.

Большинство моделей поставляются с правилами их использования. Взлом джейлбрейка позволяет пользователям манипулировать системой искусственного интеллекта и генерировать результаты, нарушающие эти правила, например, писать код для программ-вымогателей или генерировать текст, который может быть использован в мошеннических электронных письмах.

Они используют различные уловки для взлома защитных механизмов, например, задают гипотетические вопросы или вопросы на иностранных языках.

Doxxing и слежка

Языковые модели ИИ - идеальный инструмент не только для фишинга, но и для доксинга (раскрытия частной, идентифицирующей информации о ком-либо в сети). Языковые модели ИИ обучаются на огромных объемах интернет-данных, включая персональные данные, и могут определить, где, например, может находиться человек.

Можно попросить чат-бота притвориться частным детективом, имеющим опыт в составлении профилей, и проанализировать текст, написанный жертвой, чтобы вывести личную информацию из небольших подсказок в этом тексте - например, возраст жертвы.

Хотя существование этих сервисов не свидетельствует о преступной деятельности, оно указывает на новые возможности, которые могут появиться у злоумышленников.

Вывод из всего этого прост — компаниям следует инвестировать в защиту данных и безопасность, а людям — дважды подумать о том, чем они делятся в Интернете, и решить, устраивает ли их то, что их личные данные используются в языковых моделях.